Решение задачи

Определить количество информации в каждой букве. Определить энтропию и избыточность источника, выдающего текст, состоящий из этих букв, при отсутствии статистических связей между буквами.

- Информатика

Условие:

Определить количество информации в каждой букве. Определить энтропию и избыточность источника, выдающего текст, состоящий из этих букв, при отсутствии статистических связей между буквами.

Решение:

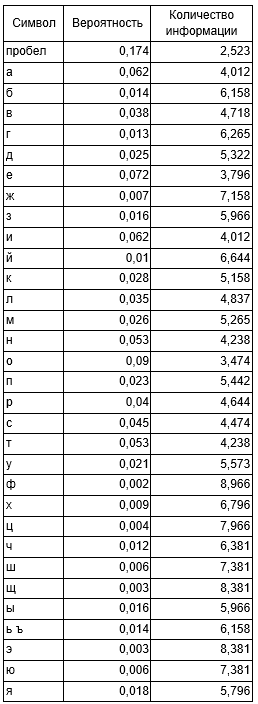

Количество информации, содержащейся в i-м символе равна log2 (1/pi), где pi является вероятностью появления i-го символа. Вычисленное количество информации для каждого символа представлено в таблице.

Энтропия источника, не учитывающего статистическую взаимосвязь между буквами, равна:

Похожие задачи

Не нашел нужную задачу?

Воспользуйся поиском

Выбери предмет

S

А

Б

В

Г

И

К

М

П

- Правоохранительные органы

- Пожарная безопасность

- Парикмахерское искусство

- Природообустройство и водопользование

- Почвоведение

- Приборостроение и оптотехника

- Промышленный маркетинг и менеджмент

- Производственный маркетинг и менеджмент

- Процессы и аппараты

- Программирование

- Право и юриспруденция

- Психология

- Политология

- Педагогика

Р

С

Т

- Трудовое право

- Теория государства и права (ТГП)

- Таможенное право

- Теория игр

- Текстильная промышленность

- Теория вероятностей

- Теоретическая механика

- Теория управления

- Технология продовольственных продуктов и товаров

- Технологические машины и оборудование

- Теплоэнергетика и теплотехника

- Туризм

- Товароведение

- Таможенное дело

- Торговое дело

- Теория машин и механизмов

- Транспортные средства

Ф

Э